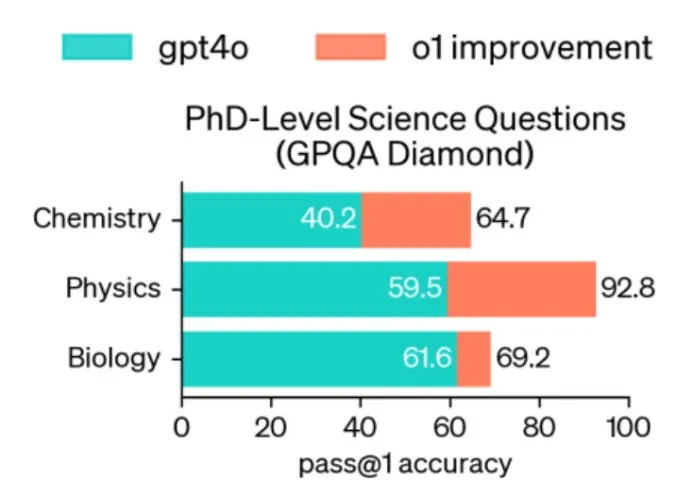

9月12日,OpenAI发布了一款新的人工智能模型OpenAI O1,引发广泛关注。按OpenAI官方的说法,O1在测试中表现惊艳,比如在物理、化学、生物等专业测试中,O1达到了相应领域里博士生的水平。当然这并不意味着O1真的超过了修炼了几年的博士同学们,毕竟刷题并不能完全检测知识积累和分析能力,更不能代表科研能力。尽管如此,O1的表现也已经让人足够惊讶了。因为长久以来,人们对大语言模型的印象是“小事尚可,正事不足”。小事尚可,是说聊聊天可以,一些知识型问题也还行;正事不足,是说一旦涉及到逻辑思考,ChatGPT们就不行了,比如数学、物理中的复杂推理。

OpenAI O1改变了这种看法,事实上它展现出了在通用领域里的某种“思维”能力。人工智能会“思维”并不罕见,比如早期的定理证明系统就是一种逻辑思维系统,只不过思维的前提和规则是人设定好的,机器只是按规则进行推理。O1通过学习,不仅学到了思维的前提(知识积累),也学到了思维的规则(推理方式)。这种思维能力的涌现可能不仅是解数学题那么简单,它是发现知识、积累知识的前提,也是人类文明能发展起来的基础。

目前我们还不知道O1的具体细节。从发布的一些零碎信息来看,可能是用了一种自我生成、自我确认的方式:模型主动生成很多思考策略,再从这些策略中发现质量较高的策略来自我学习,逐步改进生成策略的能力。在实际解题时,同样应用这种自我生成方式,因此生成的策略越多,就越有可能得到正确答案。比如在AIME数学测试中,GPT-4o在所有参赛者中的排位仅为12%,而生成一个策略的O1可以拿到74%的排位;如果生成1000个策略,排位可到93%,足以进入美国前500名。O1对大多数人可能不会有太大影响。OpenAI也说了,GPT-4o在大多数场景下还是优秀的。然而,对于人工智能本身来说,O1可能是个拐点,因为一个会“思考”的AI可以做很多重要的事情,比如与基础学科更加紧密地融合,带来更基础性的创新。

供稿:清华大学 王东

制作:北京邮电大学 戴维

审核:北京邮电大学 李蓝天