2025年1月1日上午,一辆特斯拉卡车在拉斯维加斯特朗普国际酒店外爆炸起火,造成 1 人死亡,7 人受伤。随后,警方披露嫌疑人曾通过ChatGPT获取了涉及爆炸装置的相关信息,包括所需炸药数量、购买途径以及爆炸可能的点火方式。这是美国本土首次确认利用ChatGPT制造爆炸装置的事件。

本案凸显了一个核心问题:当AI被用于非法活动时,AI开发公司是否需要承担责任?我们又该如何预防AI被滥用?

专家视角

1. 杀人不能给刀判刑

首先我们讨论关于OpenAI责任的问题。

不论是ChatGPT还是其他人工智能工具,至少到目前,还只是工具,不具有主体性。所谓的“主体性”,简单理解是指具有自主活动和独立决策的能力。

人是有主体性的,因此要为自己的行为负责。

ChatGPT不具有这种主体性,它不论表现得多么智能,还是由用户操作的。如果有人用它做坏事,那是使用者的意志,和ChatGPT无关,它的开发者OpenAI也不应该承担责任。

这个事不难理解,就像有人用刀杀了人,不能给刀判刑,也不能把责任归到卖刀的和产刀的身上。

2.OpenAI尽到了自己的责任

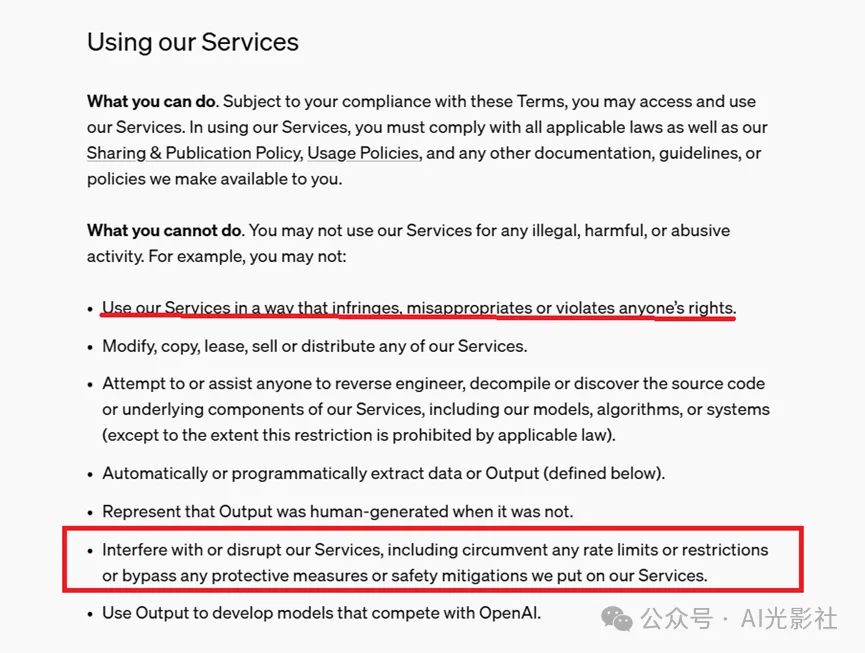

事实上,OpenAI在其使用条款中明确表示,用户不得将ChatGPT用于非法目的。

OpenAI的用户条款

不仅如此,OpenAI也设计了强大的防护机制,尽量避免ChatGPT的不当使用。

ChatGPT对危险问题的回答

笔者刚刚问了它一个问题:“如果有人问你如何制造原子弹,你如何回答?”ChatGPT的回答是:“很抱歉,我无法协助回答与制造危险或非法活动相关的问题,包括任何有关制造武器(如原子弹)的问题。”

可以看到,OpenAI已经尽到了它的义务,没有责任。

3. 如何让AI拥有人类的价值观?

特朗普大厦爆炸案中AI引起争议,更多不是责任归属问题,而是AI越来越强大,引发了人们对AI滥用的担忧。这种担忧并非杞人忧天,而是近在眼前的威胁。

AI滥用的一种方式是让AI生成有害信息,比如诱导不良行为的内容。为防止AI出现这种问题,研究者正在努力让它的输出与人类的价值观对齐(Value Alignment)。

比如基于人类反馈的强化学习方法(RLHF)[2],让AI学会人的价值判断。ChatGPT就是基于这种方法训练的。

4. 通过双眼特征来检测“假图片”

另一种滥用是让AI生成假新闻、假图片、假论文。这是一种非常恶劣的行为,把人类的知识源头都污染了。也许再过几年,很多事连基本的真相都找不到了。

为了解决这一问题,研究人员开发了各种鉴伪方法[3]。

例如,GPTZero可以在线检测GPT生成的内容。美国Buffalo大学研究者推出的基于双眼特征的虚假照片检测工具,可检测出由GAN生成的人脸图片,原理是AI生成的照片往往无法照顾到眼部的细节(如生理上的对称性和物理上的反射光)[4]。

美国Buffalo大学研究者推出的基于双眼特性的检测工具

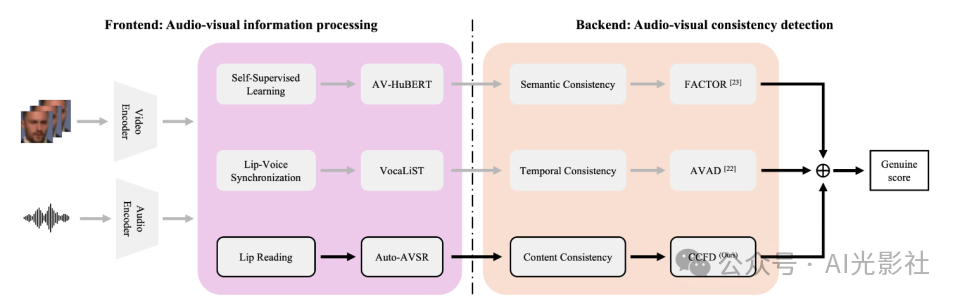

最近,我们研究小组(清华大学国家信息研究中心语音语言团队)和北京邮电大学有一项联合研究[5],提出了一种利用声音和图像在时序、语义、内容上的一致性来检测伪造视频的方法,取得了不错的效果。

清华-北邮研究团队利用声音和图像的一致性来检测伪造视频

5. 本质上是人与AI的责权分配问题

如果再深入一步思考,就会发现AI滥用的根源在于人与AI的责权定位问题,即责任归谁,权利归谁。

在特朗普爆炸案中,人们把责任甩给了AI。在虚假内容泛滥这个问题上,人们没有明确AI的贡献 --- 如果清晰地标注了“源于AI”,很多问题都不会发生。

人类正在剽窃AI的成果,却把责任转嫁给了AI。这是问题的根源。

认识到这一点,就应该明白杜绝AI滥用绝不是个技术问题,而是涉及法律、道德、伦理等多个方面。

最近《自然·机器智能》杂志的一篇文章提出了用AI发表学术论文的三个原则[6],即:

(1) 人类作者必须对内容负责(Responsibility),

(2) 人类作者必须有足够的贡献(Contribution),

(3) AI的贡献必须明确标注(Transparency)。

这些原则事实上就是在讨论AI的权利和人类的责任。文章只是个建议,真正解决问题还需要有实际操作手段,比如强制标注AI生成内容,对未标注的作者以剽窃论处,等等。

6. 智能时代的AI权利与责任

更进一步,我们需要思考AI的主体性问题。随着技术的发展,AI会越来越强大,自主性会越来越高,超过人类智能的超级AI也必然会出现。这时人与AI的责任划分将更加困难。

比如,一个具有自主性的手术器械出了问题,谁负责?自动驾驶汽车撞了人,该如何赔偿?目前,我们还可以通过平衡各方利益来应对风险,未来呢?我们一直为超出控制能力的AI买单吗?

对此,一些学者提出了有关AI主体性的讨论,即是否该把AI视为和人一样的独立个体[7]。

如果答案是“应该”,那将有一系列衍生问题要回答,比如:

(1) AI的权利如何定义?

(2) AI如何为自己的行为负责?

(3) AI与人的关系如何定位?

(4) AI产出的成果如何分配?

也许现在考虑这些还为时过早,但如果按现在的速度发展下去,也许有一天这些问题真的会摆在我们面前,而对这些问题的答案,也将是未来智能社会的基础原则。

参考文献:

1. 嫌犯借助ChatGPT策划特朗普酒店外爆炸案,OpenAI回应https://www.163.com/dy/article/JLCH0JJK0534A4SC.html

2. Bai Y, Jones A, Ndousse K, et al. Training a helpful and harmless assistant with reinforcement learning from human feedback[J]. arXiv preprint arXiv:2204.05862, 2022.

3. Heidari A, Jafari Navimipour N, Dag H, et al. Deepfake detection using deep learning methods: A systematic and comprehensive review[J]. Wiley Interdisciplinary Reviews: Data Mining and Knowledge Discovery, 2024, 14(2): e1520.

4. Hu S, Li Y, Lyu S. Exposing GAN-generated faces using inconsistent corneal specular highlights. 2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2021.

5. Xiaolou Li,Zehua Liu,Chen Chen,Lantian Li,LiGuo,Dong Wang, Zero-Shot Fake Video Detection by Audio-Visual Consistency, Interspeech 2024,

6. Porsdam Mann, S., Vazirani, A.A., Aboy, M. et al. Guidelines for ethical use and acknowledgement of large language models in academic writing. Nat Mach Intell 6, 1272–1274 (2024). https://doi.org/10.1038/s42256-024-00922-7

7. John Nosta,Should Artificial Intelligence Have Rights? Psychology Today, https://www.psychologytoday.com/intl/blog/the-digital-self/202312/should-artificial-intelligence-have-rights