最近,一款称为ChatGPT的人工智能系统火出了天际!它不仅上知天文下知地理,还可以写小说、制标书、做算数、编代码、调bug... 难怪有人惊呼,人工智能修炼成精了!

那么,如此强大的ChatGPT是怎么炼成的呢?

其实,它背后的原理并不神秘。故事还得从语言模型说起。语言模型是一项古老的技术,比如我们每天都会用到的输入法,只要输入一个词,系统会自动提示下一个词。这一背后的原理就是语言模型在默默工作。

直观理解,语言模型的任务就是告诉我们哪些词连在一起是有意义的、常用到的,而哪些则是没有意义的、不常见的。举例来说,比如“打 酱油”、“打 电话”、“打 苍蝇”都是常见的,而“打 太阳”、“打 空气”就不常见了。

传统语言模型通常是通过往前面看几个词来预测下一个词的。例如,如果前面三个词是“拿 蝇拍 打”,那么第四个词很有可能是“苍蝇”,而不是“酱油”。一般来说,模型往前看的词越多,意味着模型对场景的理解越清晰,因此其预测也就越准确。然而,由于模型结构的限制,传统语言模型的视野通常不会超过10个词。

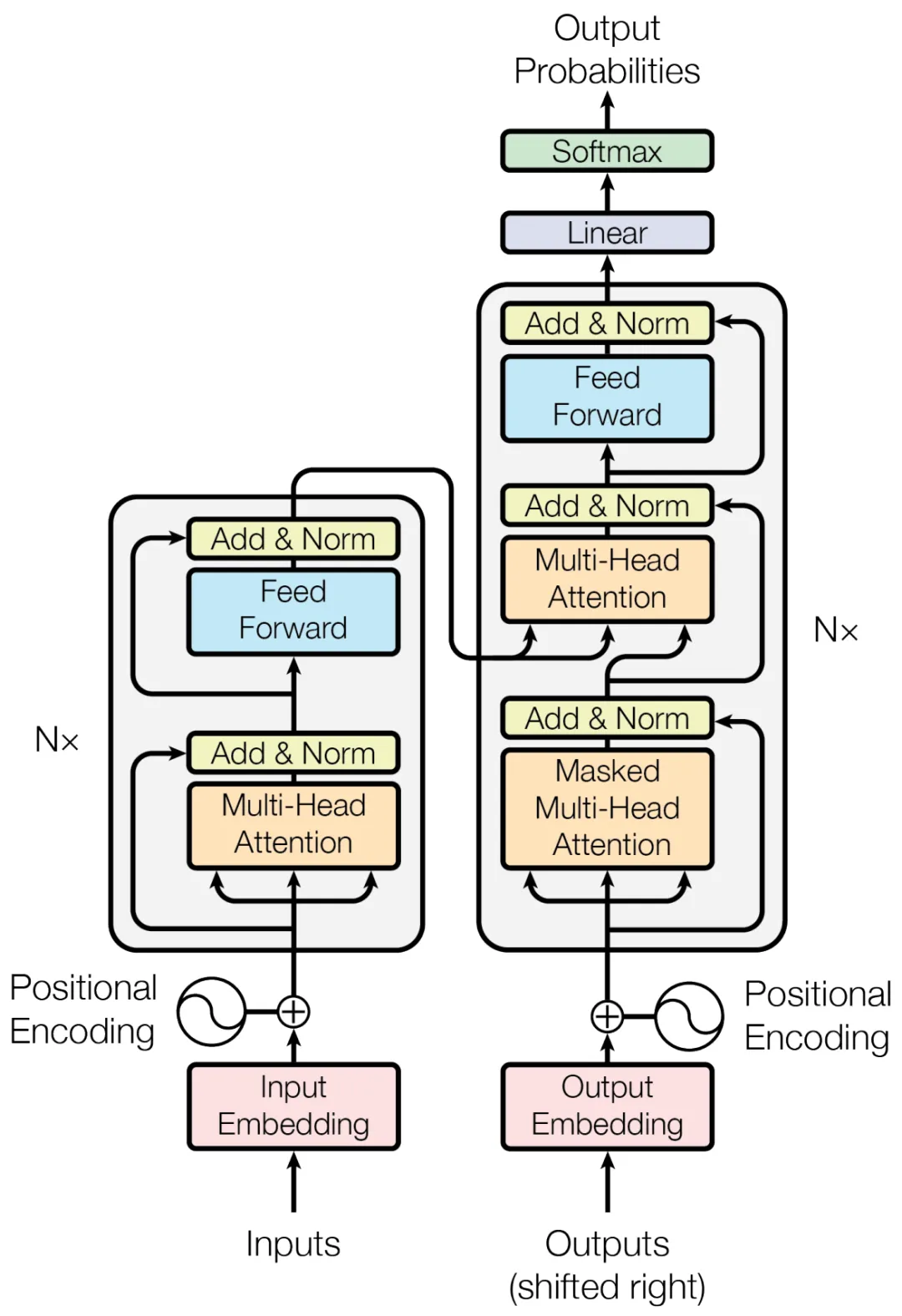

革命发生在2017年,这一年,谷歌的研究者提出了一种称为Transformer的神经网络模型。不同于传统语言模型,Transformer将其视野放大到整句话甚至整篇文章,从而实现了非常强大的语言模型。考虑下面的填空题:“妈妈去菜市场,她给我们买了很多东西,比如____”。问:空格处要填什么呢?传统语言模型很难给出合理的答案,但Transformer可以看到并理解整个句子的语境,发现妈妈去的是“菜市场”,那买的东西很可能是黄瓜、西红柿等蔬菜,而不可能是家具,也不可能是宠物。

Transformer模型结构[1]

Transformer的强大建模能力引起了研究者们的极大兴趣,其中就包括OpenAI的科学家们。他们在2018年推出了一个基于Transformer的大规模语言模型,称为GPT[2],并在2020年升级到GPT-3[3]。这一巨无霸模型包括1750亿参数,训练这一模型使用了45TB文本语料,几乎涵盖了人类所有的信息源,包括大量的网上论坛、问答社区的数据等。通过学习如此多的资料,GPT-3几乎掌握了人类的所有知识,可以说已经超越了人类的最强大脑。

另一方面,这一模型拥有超大的上下文视野,可以描述长达2048个词的语境。这一超大视野不仅使得生成的句子前后连贯,还赋予了强大的语境感知能力,让模型能够“理解”人的意图。例如,当输入是“我喜欢苹果”这句话时,如果我们给GPT-3预先输入的指令是“把汉语翻译成英语”,它将会以这一指令为语境,生成“I like apple”;反之,如果预先输入的指令是“给出原因”,那么输出将是“因为苹果有营养”。在不同的指令下生成不同的输出,就好像理解了人的指令一样。

在2022年初,OpenAI推出GPT-3.5,该版本加入了代码生成能力;同年11月底,在GPT-3.5的基础上,ChatGPT横空出世[4]。与历代GPT相比,ChatGPT最大的不同在于引入了人类的对话行为和价值观。为此,研究者们收集了大量人与机器的对话数据和评价数据,用这些数据对GPT-3.5进行改进和增强,最终得到了今天智近乎妖的ChatGPT。

总结起来,ChatGPT的强大首先应归功于它超大规模的训练数据,几乎覆盖了人类的所有知识源。其次,要归功于它超大的上下文视野以及由此带来的场景感知能力,使得它能理解当前的对语状态和人的对话意图。最后,通过学习人类的行为方式和评价标准,ChatGPT表现得更像人类。

当然,ChatGPT也有缺点,特别是它一本正经胡说八道的样子饱受诟病。尽管如此,也不可否认它所带来的变革。这种变革不仅是它改变了我们知识获取的基本方式,更重要的是它引发了我们的深入思考,即当一个人工智能系统掌握了大量知识后,它可能产生我们意想不到的创新和灵感。

参考文献:

[1] Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need[J]. Advances in neural information processing systems, 2017, 30.

[2] Radford A, Narasimhan K, Salimans T, et al. Improving language understanding by generative pre-training[J]. 2018.

[3] Brown T, Mann B, Ryder N, et al. Language models are few-shot learners[J]. Advances in neural information processing systems, 2020, 33: 1877-1901.

[4] https://openai.com/blog/chatgpt

By:清华大学 王东